2024年的GPU技术领域的动态看起来非常激动人心!英伟达、英特尔以及Meta都在不同的方面推出了令人印象深刻的新产品和技术。

英伟达的Blackwell B200:这是一款巨大的GPU,内部集成了2080亿个晶体管,尺寸是其前一代的两倍;采用了定制的两掩模版极限 N4P TSMC 工艺进行制造,通过10TBps的芯片到芯片链路连接成为单个GPU;采用了Chiplet技术,在单个封装上配备了两个GPU芯片,并通过高带宽I/O链路连接;提供192GB的HBM3E内存,内存总带宽为8TB/s。

英特尔的Gaudi 3加速器:这是英特尔子公司Habana Labs的下一代高性能人工智能加速器。集成了HBM2e内存控制器,每个芯片提供128GB的内存,总内存带宽为3.7TB/s。采用了Chiplet设计,每个芯片配备了两个计算Die,转向了具有两个计算集群的Chiplet的设计。

Meta的下一代训练和推理加速器:集成了LPDDR5 内存控制器,单芯片可扩展128GB LPDDR5内存,总内存带宽为204.8GB/s;采用TSMC 5nm的工艺带来了90W的功耗表现;该芯片的架构从根本上侧重于为服务排名和推荐模型提供计算、内存带宽和内存容量的适当平衡。

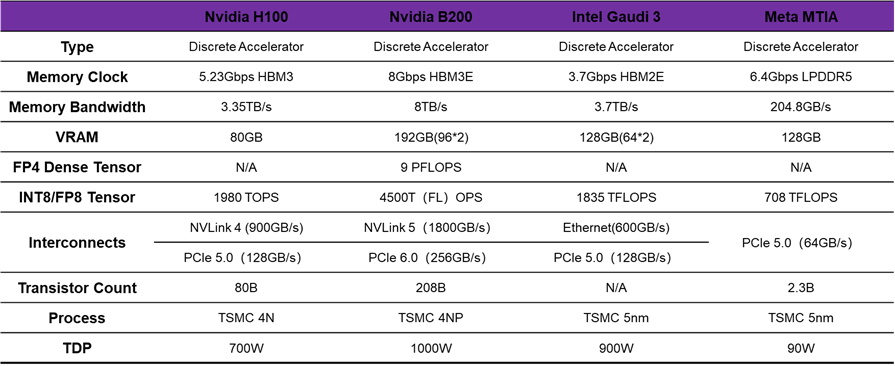

小编根据市场上应用的标杆H100,整理了下面的硬件参数对照表。

可以看到,2024年GPU科技领域的角逐依旧火热,各大科技巨头争相推出新一代的创新产品和技术。英伟达、英特尔以及Meta在AI算力领域展开了一场激烈的竞争,为了让我们更好地理解这一场景,让我们先来梳理一下最新的四大趋势。

NVIDIA B200 and Intel Gaudi 3

Chiplet技术的崛起

从霄龙二代和锐龙三代开始,AMD就采用CPU Die + IO Die的Chiplet组合方式来扩展CPU算力,自此Chiplet技术被广泛的传播开来。本次发布的NVIDIA B200在单个封装上配备两个 GPU 芯片,据 NVIDIA 称,这两个芯片作为“一个统一的CUDA GPU”运行,可提供完整的性能,其关键在于芯片之间的高带宽I/O链路,NVIDIA 将其称为NV高带宽接口 (NV-HBI:NV-High Bandwidth Interface ),并提供 10TB/秒的带宽。自此,NVIDIA 终于在他们的旗舰加速器实现了Chiplet化。Intel Gaudi 3采用的是台积电5nm工艺,在芯片设计上,Gaudi 3转向了具有两个计算集群的Chiplet的设计,而不是Gaudi 2所采用的单个集群的方案。这与NVIDIA最近发布的Blackwell加速器类似,两个相同的芯片被放置在一个封装上,并通过高带宽链路连接,以便为芯片提供统一的内存地址空间。Intel没有透露连接芯片的芯片到芯片链路的任何重要细节,目前尚不清楚实际上有多少带宽可用于跨越die。

HBM依旧是AI领域内存扩展的主流

NVIDIA B200提供192GB的HBM3E,每个Chiplet与4个HBM3E内存堆栈配对,总共8个堆栈,形成 8192 位的有效内存总线宽度。该芯片的HBM内存总带宽为8TB/秒,每个堆栈的带宽为 1TB/秒,即每个引脚的数据速率为 8Gbps。内存总带宽几乎是H100内存带宽的 2.4 倍。

Intel Gaudi 3集成了HBM2e 内存控制器,与 Gaudi 2 支持的内存类型相同,国内头部AI企业现有产品基本也是集成HBM2e内容。由于其坚持使用 HBM2e,可用的最高容量堆栈为 16GB,为加速器提供了总共 128GB 的内存。其时钟频率为 3.7Gbps/pin,总内存带宽为 3.7TB/秒。每个 Gaudi 3 芯片都提供 4 个 HBM2e PHY,使芯片的内存堆栈总数达到 8 个。

PCIe 6.0的应用

随着GPU算力的不断提升,对于数据传输速率的需求也日益增长。Astera Labs展示了PCIe 6.0连接技术,应用于英伟达的Blackwell B200,为其提供了更高的数据传输速率和更强的扩展性能。这标志着PCIe 6.0在GPU平台上的首次落地,为未来的GPU技术发展奠定了坚实的基础。

光互连与电互联的并存

英伟达还公布了由GB200驱动的GB200 NVL72,这是一个多节点、液冷、机架式系统,适用于计算最密集的工作负载。它结合了36个Grace Blackwell超级芯片,其中包括72个Blackwell GPU和36个Grace CPU,通过第五代NVLink互连。为了支持下一代AI加速芯片,Meta也开发了一个大型机架式系统,最多可容纳 72 个加速器。它由三个机箱组成,每个机箱包含 12 个板,每个板包含两个加速器。

英伟达发布的GB200 NVL72这个架构引发了光互连和铜互连的争议。引用信息平权的总结就是GB200 NVL72通过Chiplet、网络、近存等等环节升级带来的系统升级,打造了一个高度浓缩和紧耦合的超节点,且因为压缩到一个rack,用铜替代了之前256卡互联的网络成本,实现了超高性价比。 光互连和电互联是紧密联系、互相补充的,所谓的"光进铜退",可能只是一个美好的愿景,两者会长期共存,负责不同尺度下的信号互联。计算与存储芯片的高速电信号必须先在package上进行一段距离的传输,再通过光学IO互联到更远的节点处。AI的爆发,导致芯片间的互联需求更加重要。长远看,电芯片与光引擎的距离会越来越短,联系会愈加紧密。

在AI浪潮的推动下,芯片间的互联需求愈发凸显其重要性。英伟达发布的GB200 NVL72以及Meta的下一代加速芯片,均对光互连与电互联技术进行了深入的探索。这些技术的实现离不开先进的IP支持。在这个背景下,奎芯科技在接口IP和Chiplet领域的研发工作显得尤为关键。

奎芯科技作为芯片产业链上游的关键技术企业,已经在短短的时间内推出了多个自研高速接口IP,如LPDDR5X、HBM、UCIe等,并在知名厂商的工艺节点上得到了验证和量产。这些IP和Chiplet产品的成功应用,不仅丰富了数据中心、汽车电子、物联网和消费类电子等领域的解决方案,更为GPU和AI技术的发展提供了强有力的支持。

展望未来,随着AI技术的不断突破和GPU技术的不断进步,对接口IP和Chiplet的需求将更加旺盛。奎芯科技将继续加大在接口IP和Chiplet领域的研发投入,推出更先进的IP产品,以助力AI技术的发展。