2024年1月25日,海力士公司发布了2023年度财报。值得注意的是,在该财报中,HBM3的营收较2022年增长了5倍。在业绩会上,公司高层表示端侧AI市场将在2025年及以后迎来重大发展。此外,海力士公司将持续推进用于人工智能的内存芯片HBM3E的量产,并致力于HBM4的研发。这一系列发言无疑引发了业界从业人员对HBM未来市场的更多期待。

HBM(High Bandwidth Memory),即高带宽存储器,按照JEDEC的分类属于图形DDR。在科普视频的第四讲《风头正劲的HBM》中,我们对HBM的3D堆叠结构、各代HBM的速率和容量等参数进行了简要介绍。通过采用硅通孔技术(Through Silicon Via,简称“TSV”),HBM实现了芯片的垂直堆叠,类似于将数个DRAM裸片像楼层一样叠加,以提高吞吐量并克服单一封装内带宽的限制。

这项创新设计,通过TSV技术的应用,成功地解决了当前DRAM领域所面临的两个核心问题:一是明显提升了可用带宽,从而使数据传输效率得到显著提高;二是有效地降低了功耗,使得HBM在性能和效能方面都取得了显著的突破。事实上,HBM被认为是当下功耗效率最高的DRAM产品,其高带宽和高延迟特性使其成为高端GPU显存的理想选择。

HBM在应对高端GPU显存的需求时,展现出其卓越的性能。其特有的高带宽和相对较高的延迟特性使其非常适用于对带宽需求较高、对延迟不太敏感的负载。在服务器领域,一种常见的应用方案是将HBM与DDR搭配使用,其中HBM负责处理高带宽小容量的数据,而DDR则处理稍低带宽但大容量的数据。这种巧妙的组合进一步优化了系统的整体性能和能效。

HBM主要应用领域

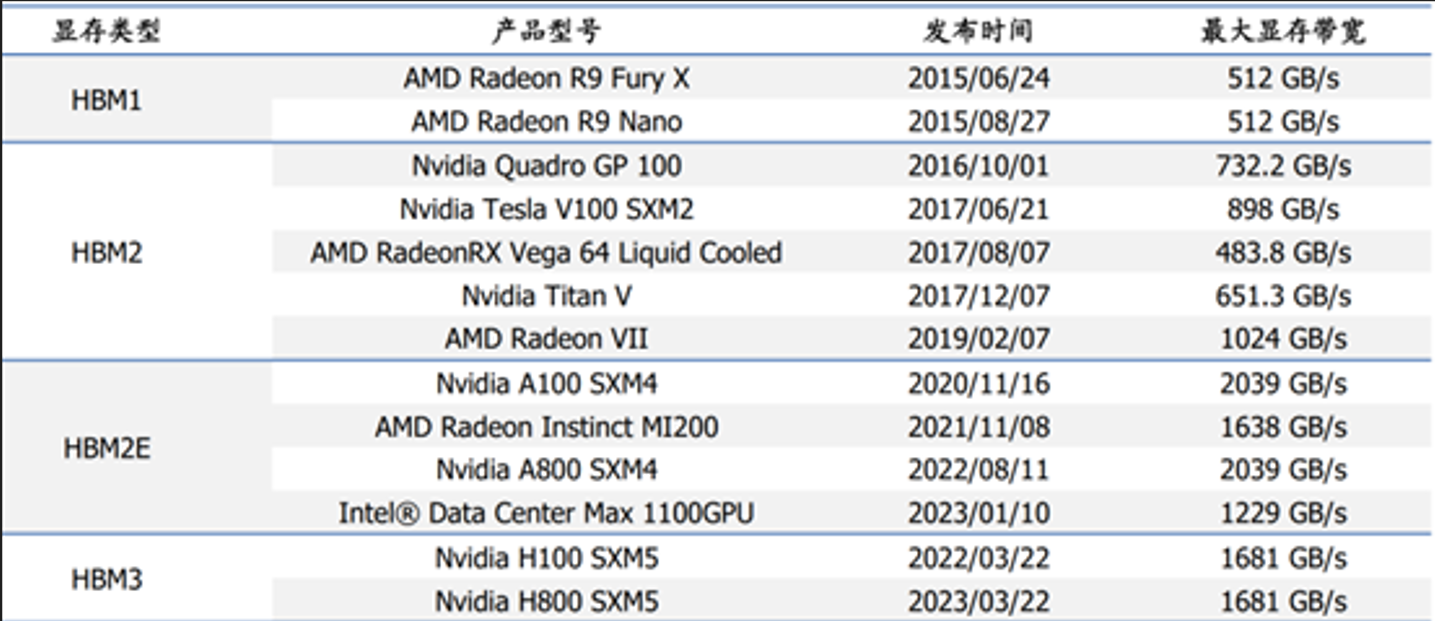

HBM广泛应用于高带宽和高容量的场景,并已成为主流AI训练芯片的常用选择。英伟达和AMD等领先厂商率先采用了HBM显存技术,其中NVIDIA的H系列产品是最早搭载HBM3的GPU产品,能够显著提升AI大模型的训练速度。

NVIDIA的H100是专为大型语言模型设计的产品,通过PCIe桥接方式,两张H100计算卡可以组成一个系统。单个H100支持高达40Tb/s的IO带宽,总共提供188GB的HBM3显存。在一个服务器中,基于四对H100和双NVLINK的配置,可以将大型模型的计算处理速度提升至少10倍。通过软硬件的优化,训练速度最高可提升30倍。

在HBM作为AI服务器最优选内存的大背景下,是否会替代传统DDR成为计算机内存的主流,仍然存在一些问题。从HBM的形态可以看出,它虽然在高带宽、高容量的场景中表现卓越,但仍然存在一些缺点。首先,HBM在灵活性方面表现欠佳。由于HBM与主芯片封装在一起,缺乏容量扩展的可能性。其规格在出厂时已被固定,无法灵活调整。其次,相较于DDR,HBM的内存容量受到更大的限制。目前主流AI/GPU芯片采用的是HBM3产品,单个HBM Stack仅能提供16GB容量,即使一颗芯片搭载了6个HBM Stack,总容量也只有96GB。与DDR相比,这样的容量仍然相对较小。第三,HBM相对于DDR而言,存在较高的访问延迟。这一特性在某些应用场景下可能成为一个不可忽视的瓶颈,影响数据的快速访问。

短期来看:

HBM很难在个人计算机(PC)领域替代DDR内存。在PC应用中,对各种随机存储访问的需求很高,而对延迟的敏感度天生更强。事实上,PC应用对低延迟的要求甚至高于对高带宽的要求。在消费市场上,常见的普通PC需要灵活地堆叠32GB以上的内存,而考虑到高端服务器通常具有96个DIMM插槽,最多可以扩展到12TB的容量。此外,还有一个非常重要的因素,即HBM的成本相对于DDR而言过高,HBM的昂贵价格成为其在个人计算机领域推广的一大障碍。

长期来看:

HBM在AR/VR设备、汽车自动驾驶等领域将会迎来更广泛的应用。在AR/VR设备方面,以HTC VIVE Pro2为例,GTX1060即可满足当前需求,并不迫切需要HBM等高带宽产品,未来随着显示需求的增加,高带宽产品的需求可能逐步增加。在汽车领域,当前的自动驾驶系统并不急需HBM的高带宽。例如,英伟达的Jetson AGX Orin采用256位的LPDDR5,其带宽最高为204.8GB/s。然而,长期来看,随着L3/L4等级别自动驾驶汽车逐渐实现,对HBM的需求也将提升。以L3级别自动驾驶为例,其带宽要求通常在600GB/s至1TB/s之间,单车可使用2个HBM2e或者1个HBM3;而对于L4级别自动驾驶,其带宽需求一般在1TB/s至1.5TB/s之间,单车可使用3个HBM2e或者2个HBM3。

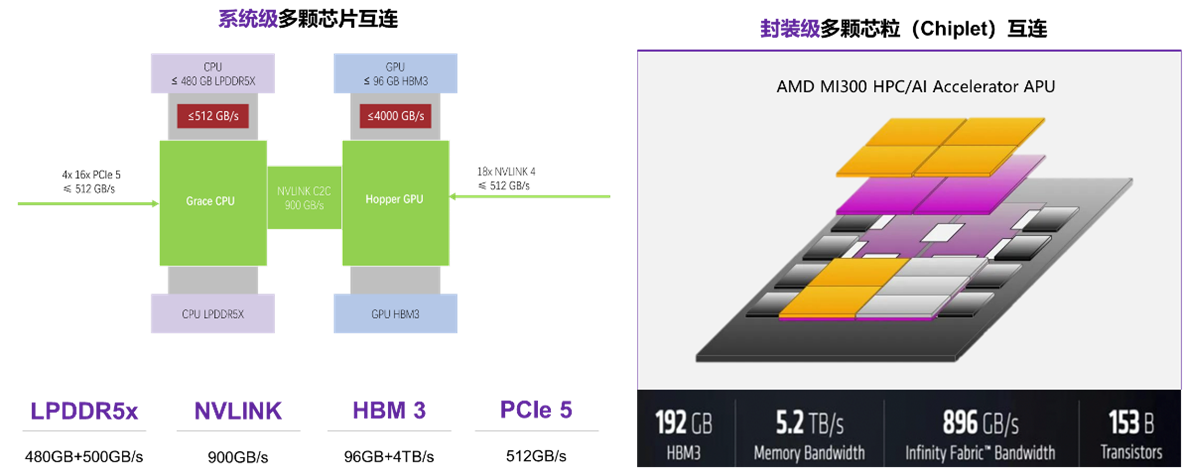

作为UCIE产业联盟的成员,奎芯科技致力于推动芯粒互联技术的发展和应用。在高速接口IP领域,奎芯科技拥有深厚的技术积累和丰富的产品系列。基于这些尖端的高速接口IP,奎芯科技提出了一种名为M2LINK的计算体系互联架构方案。

M2LINK包含三种Chiplet方案:C2IO,与串型总线接口相联;C2M,与内存总线相连;以及C2C,实现计算Die之间的互联。奎芯科技将不断努力以满足Chiplet领域芯片设计企业的需求,并致力于打造一个开放生态的Chiplet服务平台,为集成芯片和芯粒行业的创新和发展提供全方位的支持。